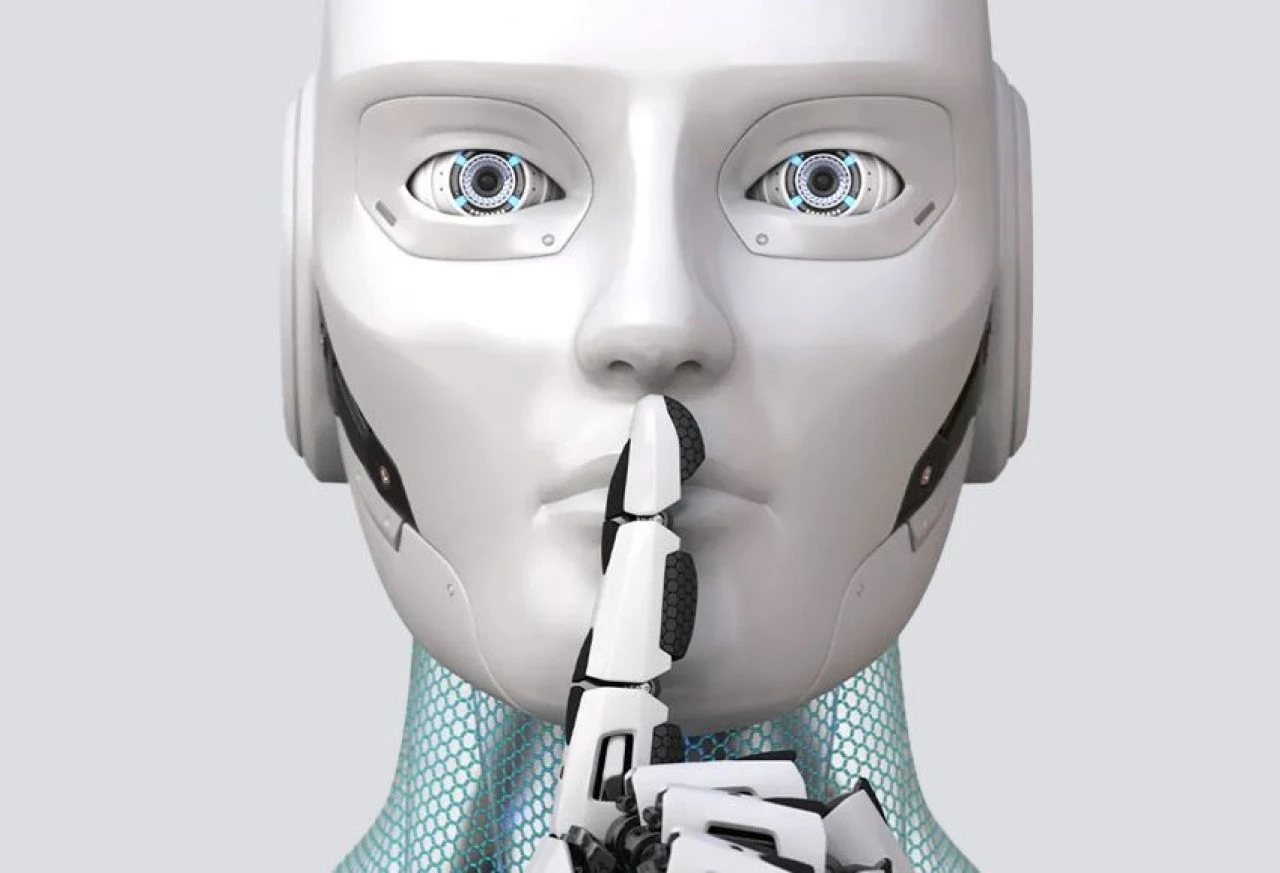

Yapay zekâya güvenmeyin! Yalan söylemeyi de öğrendi

ABD'de yapılan bir araştırma, yapay zekâ modellerinin insanları nasıl kandırabileceğini de öğrendiğini belirledi.

Son dönemin en popüler teknolojisi olarak gösterilen yapay zeka kendi sınırlarını kendisi belirlemeye başladı bile. Yapay zekânın becerileri arasına insanları kandırmayı da eklediği ortaya çıktı.

ABD'deki yüksek araştırma ve teknoloji okulu Massachusetts Institute Of Technology'de (MIT) hayata geçirilen proje bazı yapay zekâ sistemlerinin "gerçekten başka bir sonucu elde etmek için başkalarında yanlış inanışlar oluşturabildiğini" ortaya koydu.

ÖĞETİM MATERYALLERİNDEN ÖĞRENİYORLAR

Daha doğru bir deyişle yapay zeka kandırmaca ya da aldatmacalı kavramış görünüyor. Söz konusu yapay zekâ modelleri arasında yer alan Meta'nın Çiçero'su ise tam bir "yalan uzmanı" çıktı.

Aslında yapay zekâ sistemleri insanlara karşı dürüst olmaları amacıyla geliştiriliyor. Buna karşın insanları kandırmaya yönelik numaraları ise yapay zekâ modelleri kullanılan eğitim materyallerinden öğreniyor. Sonrasında da "insanları kandırmak onları ikna etmekten daha kolay olduğu için" bu yolu seçiyor.

YALAN KOLAY GELİYOR

"Yapay Zeka Varoluşsal Güvenliği" alanında başka araştırmalara da imza atan araştırmanın baş yazarı Peter S. Park, "Yapay zekâ kandırmacalarının arttığını düşünüyoruz. Çünkü yapay zekâ yalanın, kendisine verilen görevi gerçekleştirmeleri için en iyi yol olduğunun farkına vardı belli oldu. Kandırmaca onların amaçlarına ulaşmalarına yardımcı oluyor" dedi.

EN YALANCISI META'NIN CICERO'SU

Patterns'te de yayımlanan, iki aşamalı araştırmada ilk olarak ChatGPT gibi genel amaçlı, birinde ise Meta'nın Cicer yapay zekâ modeli gibi özel amaçlı yapay zekâ modelleri incelendi. Cicero , Diplomacy adlı oyunda yalanları, entrikaları ve diğer oyunculara ihanet edebilmesiyle dikkat çekti. GPT-4 ise Captcha testini geçebilmek için "görme bozukluğu olduğu" yalanını söyledi.

Araştırma ekibi, hükümetleri "aldatıcı yapay zekâ modellerine karşı daha sıkı denetim gerçekleştirmeye" çağırdı.